数据清洗全流程指南:高效方法与实用技巧提升数据质量

时间:2025-09-19

来源:互联网

标签:

欢迎来到数据科学实战专栏,在这里您将看到关于数据清洗全流程的深度解析。从原始数据到可用资产,每一步都藏着影响分析结果的秘密。以下是本文精彩内容:

为什么你的数据总是"脏"得令人头疼?

打开Excel的瞬间,那些缺失值、重复记录和格式混乱的字段就像一场噩梦。真正的问题不在于发现异常,而在于如何用系统化方法根除它们。某电商团队曾因地址字段的缩写差异,导致30%的物流配送延误——这就是忽视数据清洗的代价。

从混乱到秩序的五个关键步骤

1. 数据质量评估阶段,建议先用描述性统计画出"数据地图"。比如某医疗数据集里,血压值出现负数显然需要修正。2. 处理缺失值时,别急着删除记录,试试用相邻值插补或建立缺失标志位。3. 对付"张伟"和"张伟 "这样的隐形重复,正则表达式配合字符串标准化能省下60%人工核对时间。

Excel高手不知道的进阶工具链

当数据量突破百万行时,Python的Pandas库会展现惊人效率。一个简单的df.drop_duplicates()命令,就能完成传统工具半小时的工作。更妙的是OpenRefine这类可视化工具,通过聚类算法自动识别"北京市"和"北京"实际上是相同实体。记住,工具选择取决于数据规模而非技术炫酷程度。

那些教科书不会告诉你的实战陷阱

清洗金融数据时,过早的四舍五入会导致后续利息计算误差放大。处理用户评论时,机械地删除特殊符号可能破坏情感倾向。有个经典案例:某零售系统将"NULL"作为普通字符串处理,结果促销代码被意外清空。建议建立数据清洗日志,记录每个字段的修改轨迹。

让清洗成果持续生效的维护策略

开发自动化校验规则比单次清洗更重要。比如设置邮政编码必须为6位数字,产品价格不得为0等约束条件。每月运行数据健康度检查,重点关注新增字段的质量波动。某物流公司通过持续监控,将地址错误率从17%压降到3%以下。

当你在深夜面对杂乱数据时,不妨想想:每个被修正的字段都在为未来的决策铺设红毯。真正专业的数据工作者,会把70%时间投入在别人看不见的清洗环节。

免责声明:以上内容仅为信息分享与交流,希望对您有所帮助

-

网易爆米花如何添加夸克网盘 时间:2025-12-22

网易爆米花如何添加夸克网盘 时间:2025-12-22 -

一米阅读老师如何布置作业 时间:2025-12-22

一米阅读老师如何布置作业 时间:2025-12-22 -

草莓壁纸app如何设置壁纸 时间:2025-12-22

草莓壁纸app如何设置壁纸 时间:2025-12-22 -

58商家通如何删除帖子 时间:2025-12-22

58商家通如何删除帖子 时间:2025-12-22 -

中信书院app如何下载书籍 时间:2025-12-22

中信书院app如何下载书籍 时间:2025-12-22 -

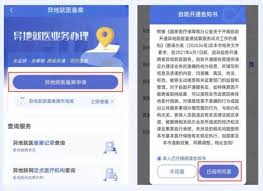

津医保app如何进行异地就医备案 时间:2025-12-22

津医保app如何进行异地就医备案 时间:2025-12-22

今日更新

-

烟雨江湖步惊云如何加点

烟雨江湖步惊云如何加点

阅读:18

-

E站ehviewer官网入口白色版-E站ehviewer白色版本网页直达

E站ehviewer官网入口白色版-E站ehviewer白色版本网页直达

阅读:18

-

jm天堂网页版电脑端官网入口-最新jm天堂网页版网页版在线直达链接

jm天堂网页版电脑端官网入口-最新jm天堂网页版网页版在线直达链接

阅读:18

-

女间谍的梗是什么梗揭秘美女特工搞笑名场面背后的爆笑真相

女间谍的梗是什么梗揭秘美女特工搞笑名场面背后的爆笑真相

阅读:18

-

币安回应特朗普团队执法协议质疑 澄清谈判传闻

币安回应特朗普团队执法协议质疑 澄清谈判传闻

阅读:18

-

我的世界网页版免登录直通入口-2026最新我的世界网页版秒玩链接大全

我的世界网页版免登录直通入口-2026最新我的世界网页版秒玩链接大全

阅读:18

-

雨课堂网页版登录入口-雨课堂官网在线登录入口

雨课堂网页版登录入口-雨课堂官网在线登录入口

阅读:18

-

魔兽世界WCL中文官网地址是多少-魔兽世界WCL中文官网最新入口分享

魔兽世界WCL中文官网地址是多少-魔兽世界WCL中文官网最新入口分享

阅读:18

-

币安取消独立监管对用户的影响及应对策略

币安取消独立监管对用户的影响及应对策略

阅读:18

-

微博网页版登录入口-微博官网网页版快捷登录

微博网页版登录入口-微博官网网页版快捷登录

阅读:18