cuDNN是什么意思 cuDNN是用来干嘛的 cuDNN和CUDA的关系

在当今人工智能和深度学习飞速发展的背景下,GPU 加速计算已经成为提升模型训练与推理效率的关键手段。NVIDIA 作为 GPU 领域的领先厂商,推出了多个重要的开发工具和库,其中 cuDNN(CUDA Deep Neural Network library) 和 CUDA(Compute Unified Device Architecture) 是两个非常核心的组件。

本文将围绕cuDNN 是什么、cuDNN 是用来干嘛的、cuDNN 和 CUDA 之间有什么关系三个问题展开讨论,通过这些内容,帮助读者全面了解 cuDNN 的功能、应用场景及其与 CUDA 的紧密联系。

一、cuDNN 是什么

定义与背景

cuDNN 是由 NVIDIA 开发的一个专为深度学习优化的 GPU 加速库,全称是 CUDA Deep Neural Network library。它基于 NVIDIA 的 CUDA 平台构建,旨在为深度神经网络提供高效的底层实现支持。

从技术角度看,cuDNN 是一个针对 GPU 的软件库,提供了大量经过高度优化的函数,用于执行深度学习中常见的操作,如卷积、池化、归一化等。它的设计目标是让开发者能够更轻松地利用 GPU 的强大计算能力,从而加速深度学习模型的训练与推理过程。

与深度学习的关系

随着深度学习模型的复杂度不断提升,传统的 CPU 计算已经难以满足大规模数据处理的需求。而 cuDNN 通过充分利用 GPU 的并行计算能力,使得深度学习算法能够在更短的时间内完成训练任务,显著提升了模型的性能。

此外,cuDNN 还支持多种深度学习框架,如 TensorFlow、PyTorch、Caffe 等,成为许多主流深度学习平台的重要依赖库之一。

二、cuDNN 是用来干嘛的

提供高效的基础运算

cuDNN 最主要的功能是提供一系列经过优化的深度学习基础运算,包括但不限于:

卷积(Convolution)

池化(Pooling)

归一化(Normalization)

激活函数(如 ReLU、Sigmoid 等)

全连接层(Fully Connected Layer)

这些操作是构建深度神经网络的核心组成部分,而 cuDNN 通过对这些操作进行底层优化,极大地提高了计算效率。

支持多层网络结构

除了基本的操作之外,cuDNN 还支持构建复杂的网络结构,例如卷积神经网络(CNN)、循环神经网络(RNN)等。它不仅提供单个操作的实现,还支持多层网络之间的组合与调用,使得开发者可以更方便地构建和训练复杂的模型。

提升模型训练速度

由于 cuDNN 是专门为 GPU 设计的,它能够充分利用 GPU 的并行计算资源,减少 CPU 的负担。这意味着在使用 cuDNN 的情况下,模型的训练时间可以大大缩短,尤其是在处理大规模数据集时效果尤为明显。

跨平台兼容性

cuDNN 支持多种操作系统和硬件平台,包括 Windows、Linux、macOS,以及不同的 NVIDIA GPU 架构。这种广泛的兼容性使得 cuDNN 成为了深度学习开发中的标准工具之一。

三、cuDNN 和 CUDA 的关系

CUDA 是基础架构,cuDNN 是应用层

要理解 cuDNN 与 CUDA 的关系,首先需要明确两者的定位。CUDA 是 NVIDIA 提供的并行计算平台和编程模型,它允许开发者直接访问 GPU 的计算资源,并编写运行在 GPU 上的代码。

而 cuDNN 是建立在 CUDA 基础之上的一个高级库,它封装了大量深度学习相关的计算操作,并利用 CUDA 提供的底层能力来实现高性能计算。因此,可以说 cuDNN 是 CUDA 的一个“应用层”组件,专门服务于深度学习领域。

cuDNN 依赖于 CUDA

由于 cuDNN 是基于 CUDA 实现的,因此在使用 cuDNN 之前,必须先安装和配置好 CUDA。CUDA 提供了 GPU 计算的基本接口,而 cuDNN 则在其基础上实现了深度学习所需的优化算法。

如果系统中没有正确安装 CUDA,或者版本不匹配,那么 cuDNN 将无法正常工作。因此,在部署深度学习环境时,通常需要同时安装 CUDA 和 cuDNN,并确保它们的版本兼容。

两者协同提升性能

CUDA 提供了底层的 GPU 计算能力,而 cuDNN 则在此基础上进一步优化了深度学习算法的执行效率。两者的结合使得深度学习模型可以在 GPU 上获得更高的吞吐量和更低的延迟。

例如,在训练一个卷积神经网络时,CUDA 负责将计算任务分配到 GPU 的各个核心上,而 cuDNN 则负责对卷积操作进行优化,确保每一层都能以最快的速度完成计算。

发展方向与未来趋势

随着深度学习技术的不断演进,NVIDIA 也在持续更新和优化 cuDNN 和 CUDA。新的版本通常会引入更多的功能、更好的性能优化以及对新硬件的支持。例如,cuDNN 逐步支持了更先进的 GPU 架构(如 Ampere、Hopper),并增加了对混合精度训练的支持。

与此同时,CUDA 也在不断扩展其生态系统,不仅限于深度学习,还覆盖了科学计算、图形渲染、AI 推理等多个领域。这表明,cuDNN 与 CUDA 的关系将持续深化,共同推动 GPU 在人工智能领域的广泛应用。

综上所述,cuDNN 是一个专门为深度学习优化的 GPU 加速库,它通过提供高效的底层计算操作,显著提升了深度学习模型的训练和推理效率。而 CUDA 是 NVIDIA 提供的并行计算平台,为 cuDNN 提供了底层的硬件支持。

以上就是php小编整理的全部内容,希望对您有所帮助,更多相关资料请查看php教程栏目。

-

核芯显卡是什么意思?核芯显卡和独立显卡有什么区别? 时间:2025-12-19

核芯显卡是什么意思?核芯显卡和独立显卡有什么区别? 时间:2025-12-19 -

什么是算术逻辑单元ALU 算术逻辑单元的功能和结构 时间:2025-12-19

什么是算术逻辑单元ALU 算术逻辑单元的功能和结构 时间:2025-12-19 -

什么是视觉识别色差检测 视觉识别色差检测的原理、技术特点、应用及常用工具 时间:2025-12-19

什么是视觉识别色差检测 视觉识别色差检测的原理、技术特点、应用及常用工具 时间:2025-12-19 -

什么是流量控制 流量控制和拥塞控制的区别 时间:2025-12-19

什么是流量控制 流量控制和拥塞控制的区别 时间:2025-12-19 -

GPU虚拟化是什么意思 GPU虚拟化有哪三种方法 时间:2025-12-19

GPU虚拟化是什么意思 GPU虚拟化有哪三种方法 时间:2025-12-19 -

独显是什么意思 独显和集显的区别 时间:2025-12-19

独显是什么意思 独显和集显的区别 时间:2025-12-19

今日更新

-

想知道派大星这个梗是什么梗?揭秘海绵宝宝里派大星的爆笑名场面!

想知道派大星这个梗是什么梗?揭秘海绵宝宝里派大星的爆笑名场面!

阅读:18

-

2925邮箱官方入口网址直达-2925邮箱一键登录官网

2925邮箱官方入口网址直达-2925邮箱一键登录官网

阅读:18

-

全球虚拟货币监管收紧,挖矿企业面临哪些挑战与机遇?

全球虚拟货币监管收紧,挖矿企业面临哪些挑战与机遇?

阅读:18

-

TikTok视频在线观看入口-TikTok官网高清视频流畅播放

TikTok视频在线观看入口-TikTok官网高清视频流畅播放

阅读:18

-

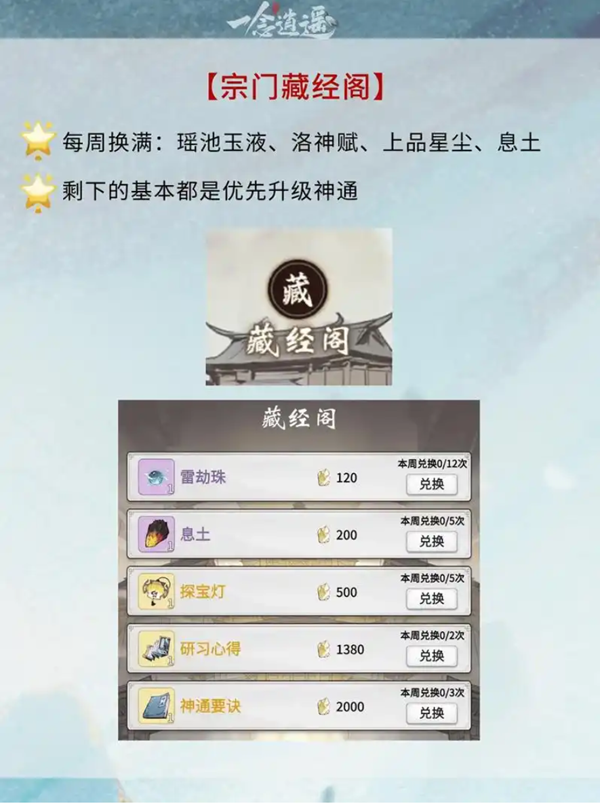

我的门派兑换码哪里领-2026最新激活码合集

我的门派兑换码哪里领-2026最新激活码合集

阅读:18

-

UC网盘如何不限速下载资源-UC网盘不限速下载资源终极教程

UC网盘如何不限速下载资源-UC网盘不限速下载资源终极教程

阅读:18

-

揭秘派对的梗是什么梗:年轻人社交新暗号,全网热议的快乐密码!

揭秘派对的梗是什么梗:年轻人社交新暗号,全网热议的快乐密码!

阅读:18

-

樱花漫画免费阅读官网入口-樱花动漫在线漫画正版入口

樱花漫画免费阅读官网入口-樱花动漫在线漫画正版入口

阅读:18

-

小型虚拟币交易平台生存危机:市场波动下的转型策略

小型虚拟币交易平台生存危机:市场波动下的转型策略

阅读:18

-

逃跑吧少年2026年最新兑换码

逃跑吧少年2026年最新兑换码

阅读:18