常见的流式计算框架有哪些 流式计算框架对比

在数据科学和大数据处理领域,流式计算框架已成为处理实时数据不可或缺的工具。这些框架允许我们高效地处理连续不断的数据流,并从中提取有价值的信息。本文将介绍几种常见的流式计算框架,并对它们进行对比,以帮助读者更好地理解和选择适合自己需求的方案。

一、常见流式计算框架简介

ApacheKafka

ApacheKafka不仅是一款分布式流处理平台,还常被用作高性能的消息队列系统。Kafka的核心概念是记录,它支持多生产者、多消费者的场景,非常适合高吞吐量的数据处理需求。

ApacheStorm

ApacheStorm是一个开源分布式实时计算系统,易于设置和操作。Storm提供了简单的API来进行实时数据处理,支持多种编程语言,并且能够保证每条消息都被处理。

ApacheSparkStreaming

ApacheSparkStreaming是基于Spark的批处理引擎的扩展,它将数据流分成一系列小批量任务来处理,从而实现准实时的处理效果。SparkStreaming的优势在于能够利用Spark生态系统的丰富资源库。

ApacheFlink

ApacheFlink是一个针对无界和有界数据流的分布式处理引擎。Flink设计上注重流与批处理的结合,能够在大规模数据处理中提供高效的流处理和灵活的窗口操作。

二、流式计算框架对比分析

性能与吞吐量

对于性能和吞吐量而言,ApacheStorm和ApacheFlink通常被认为是最快的框架,因为它们专为低延迟和高吞吐量而设计。而ApacheKafka虽然主要用于消息传递,但在流处理方面也表现出色,尤其是在数据集成上。

易用性与生态系统

从易用性和生态系统角度来看,ApacheSparkStreaming由于Spark的广泛使用和成熟的社区支持,对于新手更加友好。同时,Spark的生态系统也为数据处理提供了强大的支持。

容错与可靠性

在容错和可靠性方面,所有提到的框架都具有一定的容错机制。Kafka通过复制机制确保数据不丢失,Storm通过ZooKeeper进行状态管理,而Spark和Flink则通过内存计算和检查点机制来保障。

语言支持

关于编程语言的支持,Storm可能是最灵活的,因为它原生支持多种语言。而Spark和Flink主要支持Scala、Java和Python,Kafka则主要通过Java进行操作。

在选择流式计算框架时,应考虑实际的业务场景和技术要求。例如,若需处理大量实时事务数据,Storm或Flink可能是更好的选择;而对于需要整合多种数据源并进行复杂分析的场景,SparkStreaming可能更合适。此外,考虑到生态系统和易用性也是重要的决策因素。无论选择哪种框架,都需要充分理解其核心概念和最佳实践,以确保能够发挥框架的最大潜力。

以上就是php小编整理的全部内容,希望对您有所帮助,更多相关资料请查看php教程栏目。

-

cmnet和cmwap选择哪个?cmnet和cmwap有什么区别? 时间:2025-12-22

cmnet和cmwap选择哪个?cmnet和cmwap有什么区别? 时间:2025-12-22 -

进程com.android.phone已停止是什么意思?怎么解决? 时间:2025-12-22

进程com.android.phone已停止是什么意思?怎么解决? 时间:2025-12-22 -

核芯显卡是什么意思?核芯显卡和独立显卡有什么区别? 时间:2025-12-19

核芯显卡是什么意思?核芯显卡和独立显卡有什么区别? 时间:2025-12-19 -

什么是算术逻辑单元ALU 算术逻辑单元的功能和结构 时间:2025-12-19

什么是算术逻辑单元ALU 算术逻辑单元的功能和结构 时间:2025-12-19 -

什么是视觉识别色差检测 视觉识别色差检测的原理、技术特点、应用及常用工具 时间:2025-12-19

什么是视觉识别色差检测 视觉识别色差检测的原理、技术特点、应用及常用工具 时间:2025-12-19 -

什么是流量控制 流量控制和拥塞控制的区别 时间:2025-12-19

什么是流量控制 流量控制和拥塞控制的区别 时间:2025-12-19

今日更新

-

木鸟民宿app密码忘记如何找回

木鸟民宿app密码忘记如何找回

阅读:18

-

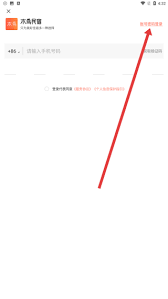

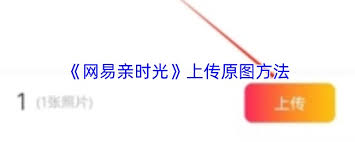

网易亲时光如何设置密码

网易亲时光如何设置密码

阅读:18

-

知识星球官网登录入口-知识星球网页版一键直达

知识星球官网登录入口-知识星球网页版一键直达

阅读:18

-

女扮男装梗指影视剧中女性角色伪装男性引发笑点或反转的经典桥段 幽默又充满戏剧性

女扮男装梗指影视剧中女性角色伪装男性引发笑点或反转的经典桥段 幽默又充满戏剧性

阅读:18

-

kk键盘如何输入我的世界代码

kk键盘如何输入我的世界代码

阅读:18

-

蛙漫2台版网页版免费在线阅读-蛙漫2台版网页版官方正版在线阅读入口

蛙漫2台版网页版免费在线阅读-蛙漫2台版网页版官方正版在线阅读入口

阅读:18

-

搜狗高速浏览器怎么显示密码保存提示

搜狗高速浏览器怎么显示密码保存提示

阅读:18

-

超级教练app扫码位置在哪

超级教练app扫码位置在哪

阅读:18

-

12306火车票余票如何快速查询-12306余票查询详细步骤【最新方法】

12306火车票余票如何快速查询-12306余票查询详细步骤【最新方法】

阅读:18

-

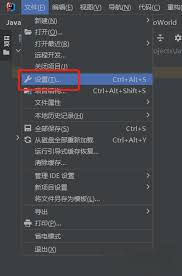

IntelliJ IDEA如何设置代码字体大小

IntelliJ IDEA如何设置代码字体大小

阅读:18