VMWARE esxi中内存总容量显示差异是怎么回事情?

时间:2010-07-13

来源:互联网

VMWARE esxi 4.01 中:

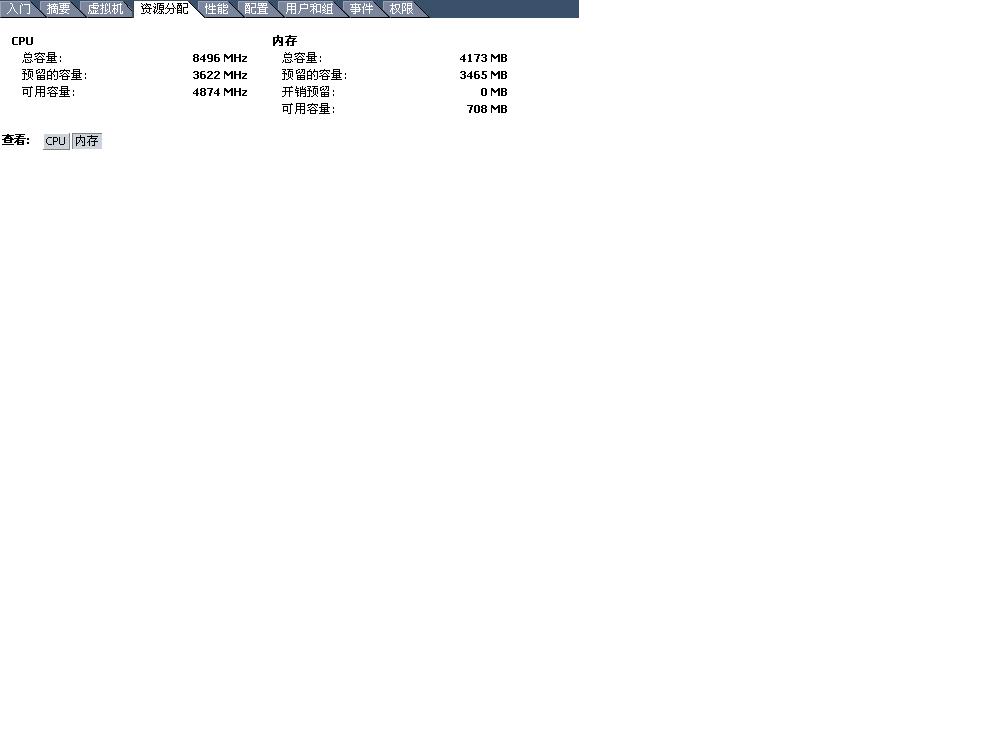

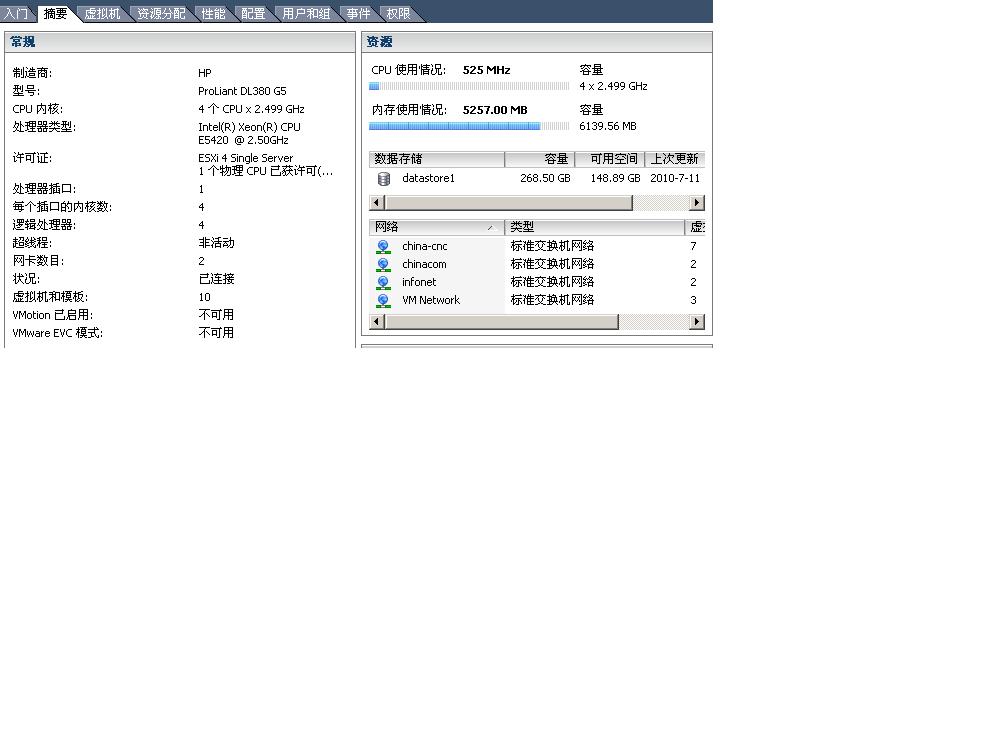

请“资源分配”中显示:

内存

总容量:4173MB

预留的容量:3465MB

但是在”摘要“中显示

内存使用情况:5221MB,

容量: 6139MB

请问这两者内存差了2G是为什么,怎么来理解?

|

esxi内存摘要.JPG (60.52 KB)

|

作者: b1uesky 发布时间: 2010-07-13

作者: dragooner 发布时间: 2010-07-13

已经贴图了。

作者: b1uesky 发布时间: 2010-07-13

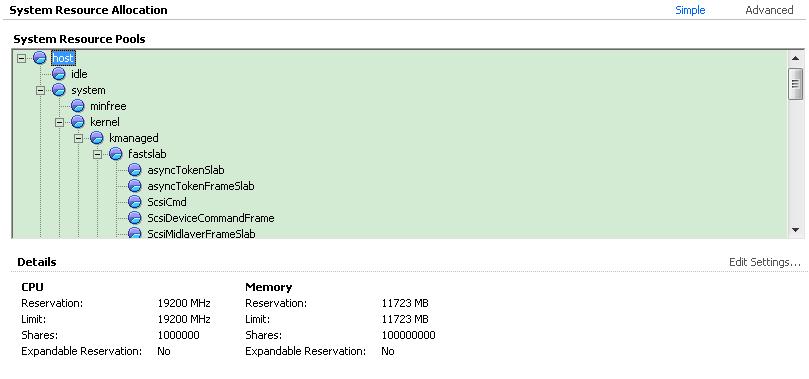

在资源分配页面看到的的是你已经分配给你的vm的容量,你可以加和一下 你已经分配给虚拟机内存的总容量。两者可能有差别。这是因为 console vm也是需要消耗内存的。

作者: dragooner 发布时间: 2010-07-13

作者: dragooner 发布时间: 2010-07-13

作者: saintdragon 发布时间: 2010-07-13

但是一个是reservation, 一个是limitation

reservation是你手动为VM预留的内存量, 这里显示的是你系统里面的和

limitation是你手动为VM设置的内存使用限量。 这里也是现实的是整个物理服务器里面的和

你可以将你所有VM的 reservation 和 limitation 给取消掉

那么这两个数字应该是归零, 或者接近于零

作者: ivyharry 发布时间: 2010-07-13

至于膨胀技术和内存透明页共享技术,这些是为了提高内存的使用效率的。

作者: dragooner 发布时间: 2010-07-13

很好,3KS。我算了一下,那应该是目前已经分配给所有GusestOS的物理内存的总和。另外我为系统本身预留了300M,摘要里边显示分配了5G的,那esxi 4.01系统本身实际目前占用的内存700M左右。这个数字也还是蛮惊人的。

作者: b1uesky 发布时间: 2010-07-13

嗯,我主要是为比较重要的服务器保留些内存。这样以后就算我建立了很多建虚拟机的时候,预留了内存的这部分虚拟机仍然可以比较正常的工作。

作者: b1uesky 发布时间: 2010-07-13

你可有物理内存和swap各占多少比例,gusetOS上用户的应用仍可以在接受范围之类的经验数据?

作者: b1uesky 发布时间: 2010-07-13

作者: dragooner 发布时间: 2010-07-14

你可有物理内存和swap各占多少比例,gusetOS上用户的应用仍可以在接受范围之类 ...

b1uesky 发表于 2010-07-13 14:35

这个看你的VM数量多少和VM是否都是同一类型了。如果开启了硬件的VT和AMD-V,ESX启用了透明内存页交换,可以节省内存

作者: saintdragon 发布时间: 2010-07-14

在各個虛擬機沒有優先權和沒有資源衝突的情況下

官方建議讓vmkernel動態分配資源

你這樣做加大了自己的工作量

到後期之後你累, vmkernel也累, VM更累

作者: ivyharry 发布时间: 2010-07-14

一般来讲,如果对自己的业务比较熟悉,同时又在使用DRS,那么关于资源池的配置就显的非常重要了。针对单个VM的意义不大。

作者: dragooner 发布时间: 2010-07-15

其实我还想建,最理想的方式是跑25个,到免费的上限。。。

作者: b1uesky 发布时间: 2010-07-15

4核心的理论上限为32个VM。

作者: dragooner 发布时间: 2010-07-16

可是他说的是vcpu只能有25个,你的意思是一个vcpu可以多个vm使用?

作者: b1uesky 发布时间: 2010-07-16

作者: dragooner 发布时间: 2010-07-21

http://www.vmware.com/cn/support ... 1_rel_notes_cn.html

增加每内核 vCPU 限制 – 每内核 vCPU 限制已从 20 提高至 25

这里我不清楚他的这个内核的含义指的一个物理CPU,还是指的一个逻辑CPU,还是指的CPU中延伸出来的一个超线程。

作者: b1uesky 发布时间: 2010-07-21

这个说法和你前期说的差距很大哦。每个内核 25vCPU和每个CPU 25 vCPU差距太大了。你的机器可是4核心的啊。按照官方的说法,至少可以有100个vCPU。如果你每个vm分配 2个vCPU,那也够50个了。但是,我知道的限制是每个物理cpu核心,最大虚拟8个VM,注意我说的是VM,不是vCPU。 现在应该明白了吧?

作者: dragooner 发布时间: 2010-07-22

回复 dragooner

那我这台单CPU的,跑了10台VM也貌似没问题呢?

作者: b1uesky 发布时间: 2010-07-22

作者: dragooner 发布时间: 2010-07-22

如何开启透明内存页交换???

作者: caoshaocong 发布时间: 2010-11-04

热门阅读

-

office 2019专业增强版最新2021版激活秘钥/序列号/激活码推荐 附激活工具

office 2019专业增强版最新2021版激活秘钥/序列号/激活码推荐 附激活工具

阅读:74

-

如何安装mysql8.0

如何安装mysql8.0

阅读:31

-

Word快速设置标题样式步骤详解

Word快速设置标题样式步骤详解

阅读:28

-

20+道必知必会的Vue面试题(附答案解析)

20+道必知必会的Vue面试题(附答案解析)

阅读:37

-

HTML如何制作表单

HTML如何制作表单

阅读:22

-

百词斩可以改天数吗?当然可以,4个步骤轻松修改天数!

百词斩可以改天数吗?当然可以,4个步骤轻松修改天数!

阅读:31

-

ET文件格式和XLS格式文件之间如何转化?

ET文件格式和XLS格式文件之间如何转化?

阅读:24

-

react和vue的区别及优缺点是什么

react和vue的区别及优缺点是什么

阅读:121

-

支付宝人脸识别如何关闭?

支付宝人脸识别如何关闭?

阅读:21

-

腾讯微云怎么修改照片或视频备份路径?

腾讯微云怎么修改照片或视频备份路径?

阅读:28